Tout ce que vous devez savoir sur l'EU AI ACT

La loi européenne sur l'intelligence artificielle (loi IA) est la première loi complète visant à réglementer l'IA en Europe. Elle introduit un système de classification basé sur les risques, fixe des obligations pour les fournisseurs et les utilisateurs, et prévoit des sanctions importantes en cas de non-respect. Cet article en présente les éléments essentiels : les quatre niveaux de risque, les échéances à venir et les dispositions déjà entrées en vigueur.

Table des matières

- Qu'est-ce que l'AI Act et pourquoi a-t-il été créé ?

- Quels sont les quatre niveaux de risque

- À qui s'applique la loi : aux fournisseurs, aux développeurs et aux utilisateurs ?

- IA générative : défis juridiques, directives et conformité dans le cadre de l'IA Act

- Quelles sont les sanctions en cas de non-respect ?

- Quel est le calendrier concret ?

Qu'est-ce que l'AI Act et pourquoi a-t-il été créé ?

L'AI Act, adopté par l'Union européenne en 2024, vise à créer un cadre juridique uniforme pour le développement, la commercialisation et l'utilisation des systèmes d'IA au sein du marché intérieur.

L'objectif est de rendre l'IA centrée sur l'humain et fiable, tout en garantissant un niveau élevé de protection de la santé, de la sécurité et des droits fondamentaux, conformément à la Charte des droits fondamentaux de l'Union européenne.

Dans le même temps, la libre circulation des biens et services basés sur l'IA doit être garantie afin de soutenir l'innovation. C'est pourquoi un équilibre délicat doit être trouvé entre la maîtrise des risques et la prévention des obstacles à l'innovation.

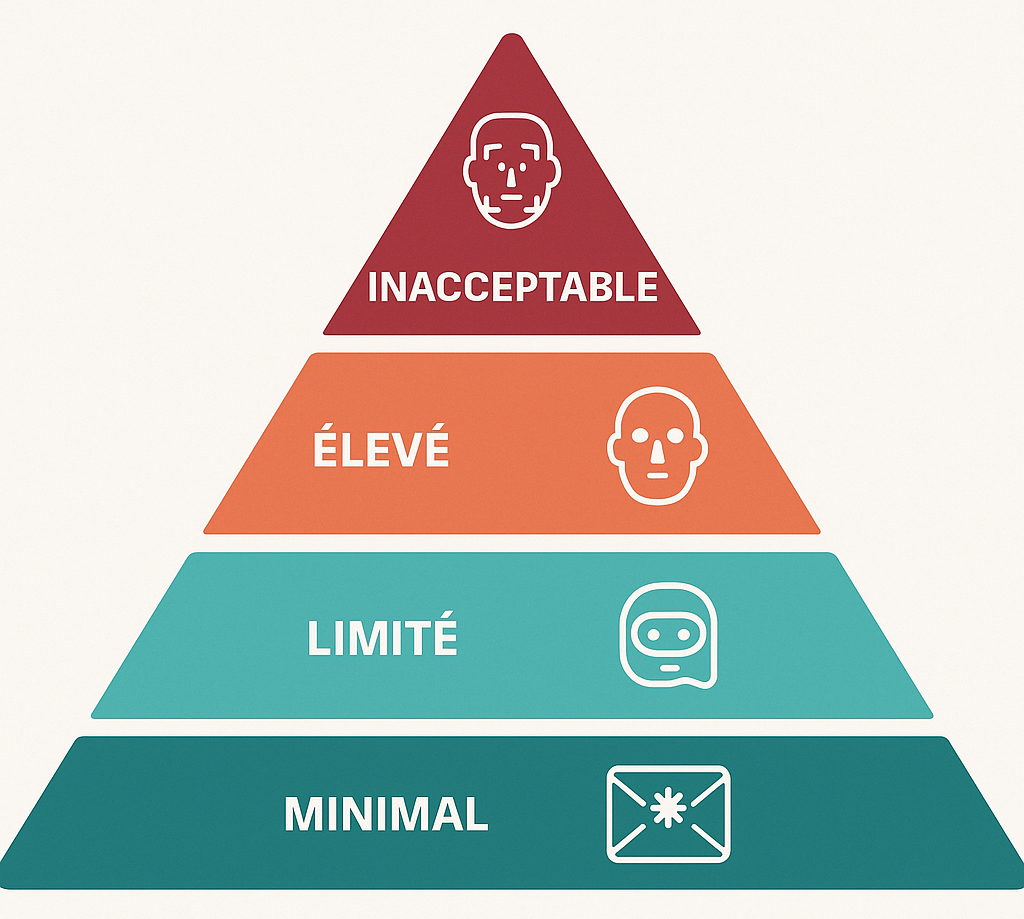

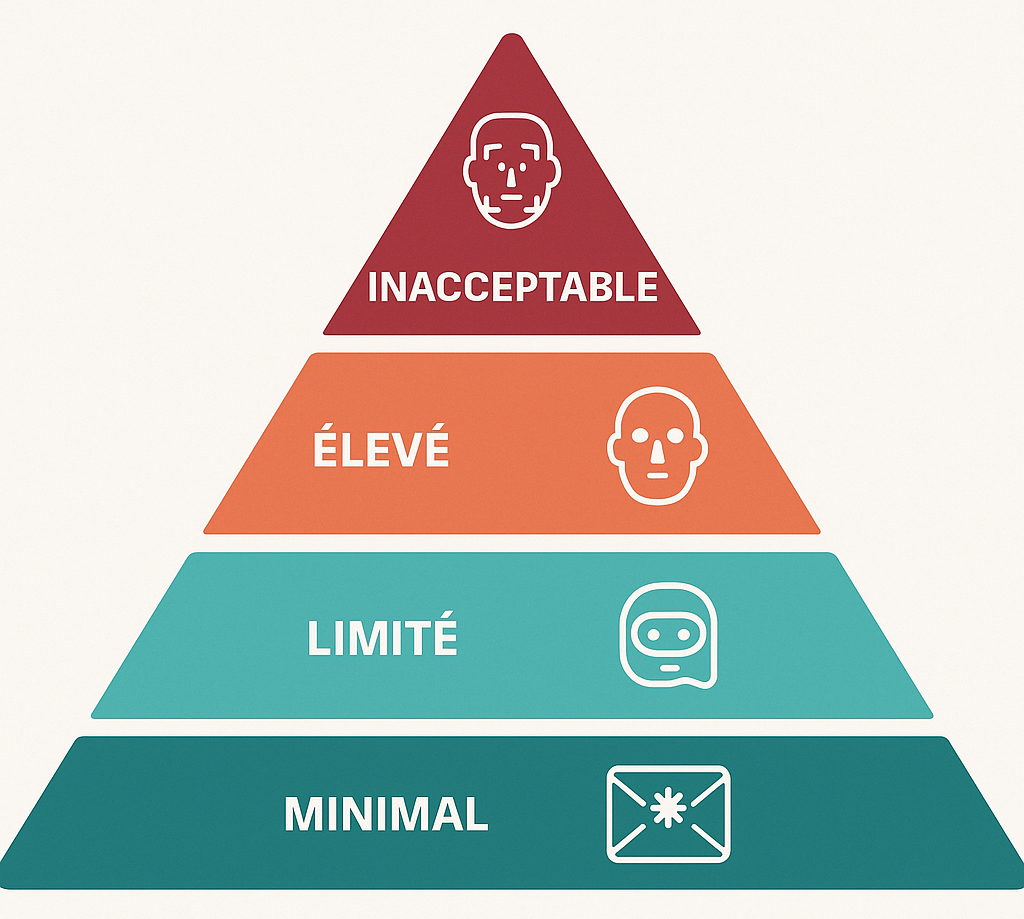

Quels sont les quatre niveaux de risque ?

La loi sur l'IA adopte une approche fondée sur les risques, dans laquelle les systèmes d'IA sont classés en quatre catégories : les systèmes interdits, les systèmes à haut risque (HRAI) et les systèmes à risque limité, et les systèmes à risque minimal.

Niveau de risque inacceptable:

Les systèmes d'IA interdits sont ceux qui présentent des risques inacceptables. Voici quelques exemples concrets :

- IA utilisée à des fins de manipulation trompeuse des personnes

- Notation sociale des citoyens, comme en Chine

- Reconnaissance faciale non contrôlée dans les espaces publics

- Classification biométrique basée sur des caractéristiques protégées, telles que la race ou la religion

- Reconnaissance des émotions au travail ou à l'école

- IA pour la prédiction des risques de crimes individuels

Niveau de risque élevé

Les systèmes d'IA à haut risque doivent respecter des obligations strictes, notamment en matière de gestion des risques, de transparence, de contrôle humain et de cybersécurité. Voici quelques exemples concrets :

- IA dans les infrastructures critiques telles que le réseau électrique ou la sécurité des transports

- Évaluation automatisée des étudiants ou des CV lors du recrutement

- Les cotes de crédit qui déterminent l'accès aux prêts

- IA pour l'identification biométrique (p.ex. la reconnaissance faciale dans le domaine de la sécurité)

Niveau de risque acceptable

Les systèmes à risque limité sont soumis à des obligations de transparence spécifiques, notamment l'information des utilisateurs sur la nature IA de l'interaction et le marquage des contenus générés artificiellement. Voici quelques exemples concrets :

- Les chatbots, où il doit être clair que l'on parle à une machine

- Les deepfakes ou contenus d'actualité générés par l'IA, qui doivent être signalés

- Les algorithmes qui interagissent avec les personnes sans avoir d'impact significatif sur leurs droits ou leur sécurité

Niveau de risque minimal

Les systèmes présentant un risque minimal ou nul s'appliquent à la plupart des applications d'IA existantes. Voici quelques exemples concrets :

- Filtres anti-spam pour les e-mails

- IA dans les jeux vidéo pour simuler des comportements

- Analyse de données de base telle que le tri automatique de fichiers

À qui s'applique l'EU AI Act ?

La loi sur l'IA s'applique à un large éventail d'acteurs de la chaîne de valeur de l'IA, notamment les fournisseurs, les responsables de l'utilisation, les importateurs, les distributeurs et les mandataires de systèmes d'IA. La loi vise les systèmes d'IA commercialisés ou mis en service dans l'Union européenne, même si le fournisseur ou le responsable de l'utilisation est établi en dehors de l'UE, à condition que les résultats du système d'IA soient utilisés dans l'UE.

L'EU AI Act établit une distinction entre les fournisseurs, qui développent des systèmes d'IA ou les commercialisent sous leur propre nom, et les utilisateurs responsables, qui utilisent des systèmes d'IA sous leur propre responsabilité à des fins professionnelles. Par contre, les personnes physiques qui utilisent des systèmes d'IA à des fins purement personnelles et non professionnelles ne relèvent pas du champ d'application.

Concrètement, voici quelques exemples d'utilisation d'outils d'IA par des cabinets d'avocats et des conseillers juridiques. Ces exemples illustrent à quel point l'AI Act imprègne le travail quotidien et les conseils prodigués par les juristes et les consultants juridiques :

- Utilisation de l'IA pour analyser la législation et la jurisprudence

- La révision automatique de contrats ou de dispositions par un logiciel d'IA, p.ex. dans le cadre de contrôles de diligence raisonnable ou de conformité

- Les chatbots et assistants virtuels sur le site web du cabinet, où les questions juridiques reçoiventjuridiques reçoivent automatiquement une réponse d'un chatbot IA

- L'automatisation des processus internes tels que la gestion des dossiers, la génération de documents ou l'enregistrement du temps par l'IA

- Due diligence dans le cadre de fusions-acquisitions et de transactions : outils d'IA pour l'analyse des risques liés aux fusions, acquisitions et co-entreprises

IA générative : défis juridiques, directives et conformité dans le cadre de l'IA Act

Qu'est-ce que le GPAI ?

Le 10 juillet 2025, le « General-Purpose AI Code of Practice » (GPAI Code) ou « Code de bonnes pratiques pour l'IA à usage général » (un code de conduite volontaire) a été publié. Il vise à aider les fournisseurs de modèles d'IA à usage général à se conformer aux nouvelles obligations de la loi européenne sur l'IA. Ce code a été élaboré par 13 experts indépendants en collaboration avec plus de 1 000 parties prenantes issues de l'industrie et du monde universitaire, notamment des fournisseurs de modèles, des petites et moyennes entreprises, des universitaires, des experts en sécurité de l'IA, des titulaires de droits et des organisations de la société civile.

L'objectif est que le code fournisse des lignes directrices pour se conformer à la loi sur l'IA, notamment en matière de transparence, de sécurité et de droits d'auteur pour les modèles d'IA à usage général tels que GPT-4, Gemini, Claude et Llama.

Défis en matière de droit d'auteur et de propriété intellectuelle

L'IA générative peut accélérer l'innovation et soutenir les processus créatifs dans de nombreux secteurs, mais elle soulève également des questions éthiques et juridiques concernant le droit d'auteur, la manipulation et la confiance dans les résultats générés. Les discussions juridiques sur le droit d'auteur des œuvres créées par l'IA restent complexes : les œuvres créées uniquement par l'IA ne bénéficient pas de la protection du droit d'auteur, sauf s'il s'agit d'une création intellectuelle propre à une personne physique. La loi sur l'IA ne contient aucune disposition spécifique concernant la protection par le droit d'auteur des créations issues de l'IA.

Il est toutefois important de noter que le Parlement européen a publié le 9 juillet 2025 l'étude « Generative AI and Copyright – Training, Creation, Regulation » (175 pages), qui devrait normalement conduire l'UE à adopter une nouvelle législation obligeant les développeurs d'IA à se conformer à des règles plus strictes, ce qui pourrait entraîner une augmentation des coûts de mise en conformité, mais aussi une plus grande sécurité juridique à long terme.

Pour aller plus loin

L'ouvrage "Le règlement européen sur l’intelligence artificielle" met en évidence les aspects essentiels du règlement européen sur la régulation de l’intelligence artificielle ( AI Act) publié au Journal officiel de l’Union européenne le 12 juillet 2024 et entré en vigueur le 1er août 2024.

Il propose une synthèse, des points clés et une analyse article par article

Obligations de formation concernant les compétences en matière d'IA

La maîtrise de l'IA est définit comme:

- la connaîssance du fonctionnement de l'IA et ses risques et dommages potentiels et leur impact sur les personnes et les groupes,

- la compréhension des systèmes d'IA prennent des décisions,

- la capacité de mise en œuvre et de surveiller l'IA de manière responsable tout en étant conscient du respect de la loi sur l'IA et des normes éthiques.

Conformément à la législation européenne, depuis le 2 février 2025, les organisations doivent former leur personnel, tant les personnes directement impliquées dans l'IA que celles indirectement concernées. Le niveau de maîtrise de l'IA dépend toutefois des systèmes d'IA utilisés, des risques et du rôle de l'employé. Aucune norme fixe n'est exigée, mais les organisations doivent garantir un niveau approprié. Cela s'applique à toutes les personnes au sein des organisations qui développent, utilisent ou sont en contact avec des systèmes d'IA.

Les juristes doivent donc eux-mêmes être compétents en matière d'IA, mais aussi être attentifs aux initiatives de formation au sein de l'entreprise dans laquelle ils travaillent ou qu'ils conseillent. Les FAQ sur la maîtrise de l'IA publiées par la Commission européenne et le « living repository » contenant des exemples pratiques constituent des outils utiles à cet égard.

Quelles sont les sanctions en cas de non-respect ?

La loi sur l'IA prévoit un système de sanctions structuré en trois niveaux, avec des amendes maximales de 7,5 millions d'euros, 15 millions d'euros et 35 millions d'euros respectivement. Ces sanctions s'appliquent à tous les opérateurs de systèmes d'IA et aux fournisseurs de systèmes d'IA générative (GPAI), le deuxième niveau s'appliquant spécifiquement aux fournisseurs de GPAI.

Les institutions, organes et organismes de l'Union européenne sont soumis à un système de sanctions distinct, avec des amendes maximales moins élevées, qui n'est pas pris en compte ici.

Les sanctions les plus sévères sont réservées aux violations de l'interdiction de certaines pratiques d'IA, avec des amendes pouvant atteindre 35 millions d'euros ou 7 % du chiffre d'affaires annuel mondial total, selon le montant le plus élevé. En outre, des sanctions sont prévues en cas de non-respect d'obligations spécifiques et de fourniture d'informations inexactes aux autorités de contrôle.

Dans le secteur financier, les prestataires de services doivent surveiller en permanence les systèmes d'IA à haut risque et signaler les incidents graves aux autorités de surveillance des marchés dans des délais stricts. En cas de non-conformité avérée, ils sont tenus de prendre immédiatement des mesures correctives, telles que la modification, le retrait du marché ou le rappel du système d'IA. En cas de non-conformité, les autorités de surveillance du marché peuvent imposer des mesures appropriées dans un délai de quinze jours ouvrables, notamment l'interdiction de proposer ou d'utiliser le système d'IA. Ces mesures coercitives s'ajoutent aux sanctions générales et visent à garantir la sécurité, la santé et les droits fondamentaux des personnes

Quel est le calendrier concret ?

1er août 2024

La loi sur l'IA, approuvée en avril 2024, est entrée en vigueur le 1er août 2024 et prévoit une application progressive de ses dispositions.

2 février 2025

L'interdiction des pratiques d'IA interdites s'applique à partir du 2 février 2025 et, à partir de cette date, les organisations doivent également former leur personnel.

2 août 2025

À partir du 2 août 2025, les obligations s'appliquent aux fournisseurs de modèles d'IA générative à usage général (GPAI), à l'exception des modèles déjà commercialisés avant cette date, pour lesquels une période de transition de 24 mois s'applique.

2 août 2026

Le 2 août 2026, la loi sur l'IA deviendra généralement applicable, y compris les obligations de transparence pour les systèmes d'IA à risque limité et les obligations pour les systèmes d'IA à haut risque (High Risk AI, HRAI) qui seront commercialisés ou utilisés à partir de cette date.

2 août 2027

Enfin, à partir du 2 août 2027, les obligations s'appliqueront aux systèmes d'IA à haut risque commercialisés ou utilisés après le 2 août 2026.

Pour aller (encore) plus loin: "Le règlement européen sur l'IA et au-delà"

Cet ouvrage analyse deux thématiques transversales novatrices proposées par le règlement : la tentative de standardisation des droits fondamentaux et l’impact du règlement sur l’IA dans différents secteurs clés.